반응형

이번 논문은 Robin Rombach et al.의 2022년 연구인 "High-Resolution Image Synthesis with Latent Diffusion Models" 입니다. 이 논문은 유명한 Stable Diffusion의 기반이 되는 논문으로, 기존의 픽셀 기반 Diffusion 모델의 한계를 극복하기 위해 Latent 공간에서 학습하는 혁신적인 접근을 제시합니다.

- Paper: https://openaccess.thecvf.com/content/CVPR2022/papers/Rombach_High-Resolution_Image_Synthesis_With_Latent_Diffusion_Models_CVPR_2022_paper.pdf

- Code: https://github.com/CompVis/latent-diffusion, https://github.com/CompVis/stable-diffusion

GitHub - CompVis/latent-diffusion: High-Resolution Image Synthesis with Latent Diffusion Models

High-Resolution Image Synthesis with Latent Diffusion Models - CompVis/latent-diffusion

github.com

GitHub - CompVis/stable-diffusion: A latent text-to-image diffusion model

A latent text-to-image diffusion model. Contribute to CompVis/stable-diffusion development by creating an account on GitHub.

github.com

🎯 배경: 왜 Latent Diffusion이 필요한가?

- Diffusion 모델은 이미지 품질은 뛰어나지만 다음과 같은 한계가 있습니다:

- 훈련과 추론 속도가 느림: 수백 단계의 노이즈 제거 과정을 반복해야 하며,

- 고해상도 이미지에 비효율적: 픽셀 단위에서 계산이 매우 무겁습니다.

- 이 논문은 위 문제를 해결하기 위해 다음과 같은 전략을 취합니다:

- "이미지 자체가 아니라, 압축된 잠재 표현(Latent Space)에서 Diffusion을 수행하자!"

💡 핵심 아이디어

- 두단계로 구성된 프레임워크

- Autoencoder (압축 단계)

- 이미지를 압축하여 저차원의 잠재 벡터 $z$로 변환

- VQ-VAE 또는 VQ-GAN과 유사한 구조

- Diffusion Model (생성 단계)

- 이 잠재 벡터 $z$를 기준으로 노이즈를 점점 제거하면서 복원

- 최종적으로 다시 Decoder를 통해 고해상도 이미지 복원

- 이 구조를 Latent Diffusion Model (LDM)이라 명명합니다.

- Autoencoder (압축 단계)

- 왜 Latent 공간에서 하면 좋은가?

- 계산량 감소: 픽셀 공간보다 훨씬 저차원 → 연산량 ↓

- 학습 속도 향상: 기존 모델 대비 수 배 빠른 학습 가능

- 고해상도 이미지 생성 가능: 메모리 효율성 덕분에 1024×1024 이상의 해상도 생성 가능

- 멀티 모달 입력에 유연: 텍스트, 레이아웃, 이미지 등 다양한 조건을 활용한 생성 가능

- 조건부 생성(텍스트, 레이아웃 등)

- LDM에서는 텍스트나 레이아웃을 조건으로 활용할 수 있습니다.

- 이때 조건은 Transformer로 인코딩된 후 UNet 구조 내부의 Cross-Attention으로 주입됩니다.

- 이 덕분에 Stable Diffusion은 자연어 설명만으로 이미지 생성이 가능합니다.

🧠 수학 없이 보는 작동 구조

| 단계 | 내용 |

| 1. 인코딩 | 입력 이미지 $x$ → 잠재 공간 $z=E(x)$ |

| 2. 노이즈 추가 | $z$에 점점 노이즈를 추가해 $z_T$ 생성 |

| 3. 디노이징 학습 | 모델이 $z_T$에서 원래 $z$를 복원하도록 학습 |

| 4. 디코딩 | 복원된 $z$ → 디코더 $D(z)$를 통해 고해상도 이미지 복원 |

📊 성능 평가

- 대표적인 성능 비교 (ImageNet 기준)

- LDM은 pixel 기반 Diffusion보다 최대 3~4배 빠름

- GPU 사용량도 훨씬 적음

- 고해상도 학습이 가능 (256×256 → 1024×1024까지)

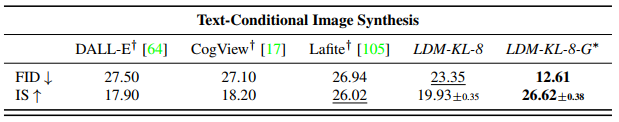

- 텍스트-이미지 생성

- Stable Diffusion의 기반

- LAION-400M 같은 대규모 텍스트-이미지 쌍을 학습하여 사용자 정의 텍스트 → 이미지 생성

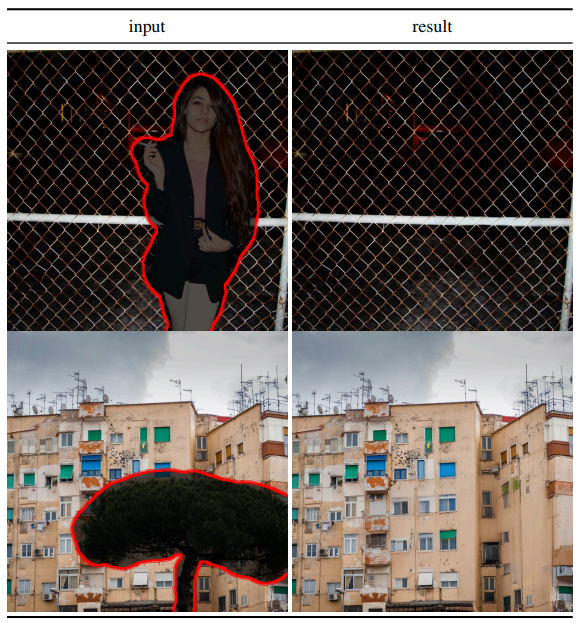

- 인페인팅 (Inpainting)

- 이미지의 일부분이 가려졌을 때, 이를 자연스럽게 복원

- LDM은 특히 고해상도 인페인팅에서 강력함

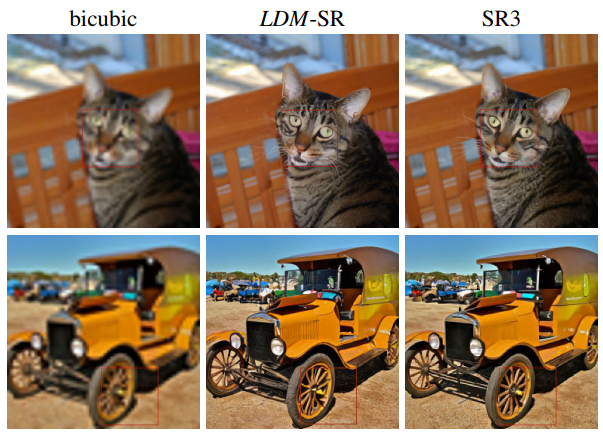

- 고해상도 영상복원(Super-Resolution)

- 저해상도 이미지 → 고해상도로 업샘플링

- LDM은 SR3보다 더 나은 FID를 기록

✅ 결론 및 요약

| 항목 | 내용 |

| 핵심 기여 | Latent 공간에서 Diffusion 수행하여 효율성 대폭 향상 |

| 구조 | Autoencoder + Latent Diffusion + Cross-Attention |

| 장점 | 속도, 해상도, 조건부 생성, 확장성에서 강력 |

| 영향 | Stable Diffusion, Midjourney, DALL·E 3 등 텍스트-이미지 모델의 기반이 됨 |

📝 마무리

- 이 논문은 단순한 구조적 변화만으로도 diffusion 모델을 현실적으로 사용 가능한 수준으로 끌어올렸습니다.

- 특히, cross-attention 기반의 조건부 생성 방식은 향후 multimodal generation의 표준으로 자리잡게 됩니다.

반응형